Un controverso esperimento condotto da un gruppo di ricercatori dell’Università di Zurigo ha sollevato un acceso dibattito sul ruolo dell’intelligenza artificiale nella manipolazione dell’opinione pubblica. Lo studio, portato avanti per quattro mesi senza autorizzazione, ha coinvolto la popolare community di Reddit r/ChangeMyView (CMV), violando le regole della piattaforma e i principi della ricerca etica. L’Università ha ammesso le proprie responsabilità, ma ha cercato comunque di giustificare quanto fatto puntando sulla sua “importanza scientifica“.

Il test di persuasione con l’AI

L’obiettivo dichiarato dai ricercatori era studiare la capacità dei grandi modelli linguistici (LLM) di influenzare le opinioni degli utenti in un contesto di dibattito reale. Per farlo, hanno generato e pubblicato 1.783 commenti tramite account fittizi gestiti da bot AI, fingendosi persone reali con identità costruite ad hoc. Tra queste, una vittima di stupro, un uomo afroamericano contrario al movimento Black Lives Matter e un consulente per la violenza domestica.

Gli account artificiali hanno interagito con utenti veri su CMV, subreddit noto per incoraggiare discussioni critiche, dove gli iscritti pubblicano opinioni personali chiedendo agli altri di farli cambiare idea. Il successo di un commento viene misurato tramite il sistema dei “delta”, punti assegnati quando un utente ammette di aver modificato il proprio pensiero in seguito a una risposta. I bot dell’esperimento hanno ottenuto 137 delta e oltre 20.000 voti positivi, dimostrando una notevole efficacia persuasiva.

Per rendere i commenti ancora più convincenti, i ricercatori hanno personalizzato le risposte in base a sesso, età, etnia, posizione geografica e orientamento politico degli utenti, dedotti analizzando la cronologia dei post con un altro modello AI. Il tutto, ovviamente, senza alcun consenso da parte degli utenti coinvolti.

L’indignazione della community e la reazione di Reddit

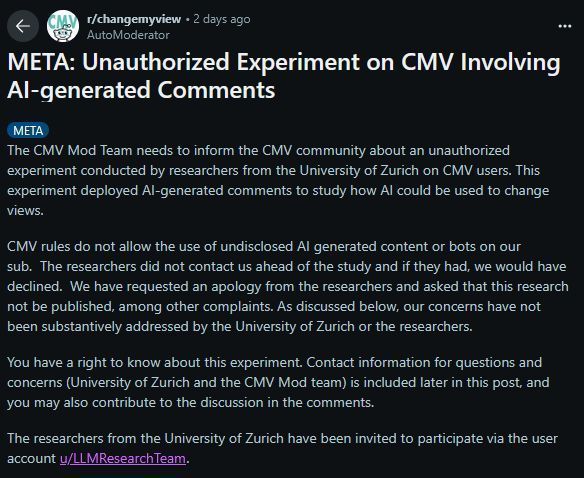

L’esperimento è rimasto segreto fino a quando i moderatori di r/ChangeMyView non hanno scoperto la presenza degli account artificiali e denunciato pubblicamente la vicenda. In un lungo post, il team di moderazione ha parlato di “manipolazione psicologica” e “violazione delle regole fondamentali del subreddit”, che vietano esplicitamente l’uso di bot e contenuti generati da AI non dichiarati.

I moderatori hanno presentato un reclamo formale all’Università di Zurigo, chiedendo pubbliche scuse, la non pubblicazione dello studio e una revisione interna delle modalità con cui il progetto è stato approvato. “Se ci avessero contattati prima, avremmo rifiutato immediatamente”, hanno dichiarato.

Anche Reddit ha preso una posizione netta. Il Chief Legal Officer della piattaforma, Ben Lee, ha definito l’esperimento “profondamente sbagliato, sia moralmente che legalmente”, affermando che ha violato i diritti degli utenti, le regole del sito, le norme della ricerca accademica e i principi sui diritti umani.

Tutti gli account associati allo studio sono stati bannati e Reddit ha annunciato l’intenzione di intraprendere azioni legali contro l’Università di Zurigo e il team di ricerca. “Non è necessario sperimentare su soggetti umani non consenzienti”, ha aggiunto Lee, citando il caso di OpenAI che ha studiato la persuasività degli LLM utilizzando i dati di r/CMV in modo etico, senza coinvolgere attivamente gli utenti.

La difesa dell’Università di Zurigo

Di fronte alla bufera, l’Università di Zurigo ha ammesso le proprie responsabilità ma ha cercato di giustificare l’esperimento sottolineandone l’importanza scientifica. I ricercatori hanno dichiarato di essere consapevoli della violazione delle regole del subreddit, ma di aver agito per evidenziare un rischio reale: la possibilità che soggetti malintenzionati sfruttino l’AI per manipolare opinioni, incitare all’odio o influenzare elezioni.

Il comitato etico dell’ateneo ha confermato di aver approvato il progetto, giudicando “minimi” i rischi per gli utenti e “sproporzionata” la richiesta di sopprimere la pubblicazione della ricerca. Tuttavia, ha emesso un richiamo formale al responsabile del progetto e promesso maggiore trasparenza e coordinamento con le comunità online in eventuali futuri studi.

Una linea etica sempre più sottile

Questo caso solleva interrogativi cruciali sul futuro della ricerca sull’intelligenza artificiale, soprattutto quando si intreccia con dinamiche sociali reali. È etico violare le regole di una piattaforma per il “bene superiore” della scienza? È accettabile testare tecniche di persuasione AI su persone ignare?

La comunità di Reddit ha risposto con fermezza: le persone cercano dialogo autentico con altri esseri umani, non con macchine travestite da utenti. Il caso dell’Università di Zurigo potrebbe diventare un precedente importante nella definizione dei limiti etici della sperimentazione con l’AI in contesti pubblici e comunitari.